juil.152022

Archéologie de l'ubique

dans la catégorie Informatologie

[…] on avait là une définition possible de la révolution informatique, comme victoire, inattendue et totale, de l’intuitionnisme […]. Mieux, cette révolution informatique serait aussi une révolution […] dans la façon de faire et de penser les mathématiques, grâce à la mécanisation du calcul et à l’automatisation de la preuve, permises par l’usage intensif de machines indifférentes à la notion métamathématique de vrai et de faux : des machines intuitionnistes.

Aurélien BELLANGER, Le continent de la douceur, Paris, Gallimard, 2019, p. 137-138

On appellera « ubique » tout ce que l’on désigne tantôt par le signifiant « informatique », tantôt – et de plus en plus – par celui de « numérique ».

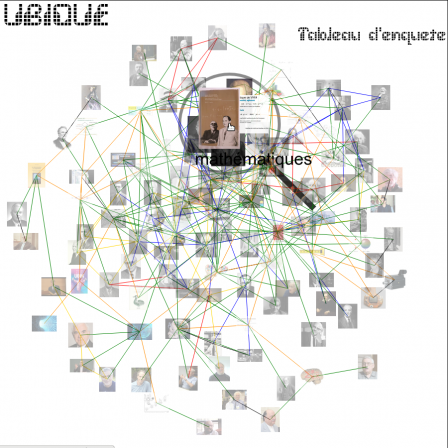

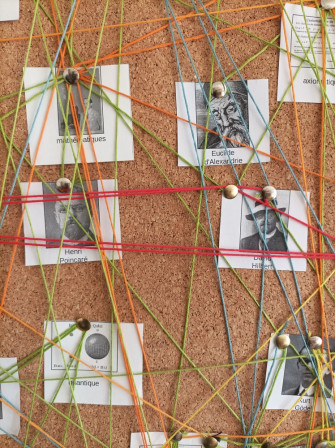

L’ubique est le nom et l’objet d’une enquête. Celle-ci a pour objectif de déterminer le caractère révolutionnaire ou contre-révolutionnaire de l’ubique. Peut-on se fier et prendre appui sur l’ubique dans une visée émancipatrice ? Ou, au contraire, l’ubique doit-elle être combattue en raison des incomparables moyens de contrôle et de domination qu’elle fournit ?

Notre enquête nous a amenés à séquencer le patrimoine génétique de l’ubique en partant d’un article d’Alan Turing de 1936. Le principal résultat en a été de révéler la nature algorithmique des modèles mathématiques constituant les objets sur lesquels opère l’ubique. Dès lors, nous avons pu identifier que la caractéristique essentielle – génétique – de l’ubique était de pouvoir traiter n’importe quel problème dans la limite de ce qui est calculable – tout en remarquant que cette limite, dès l’origine de l’ubique, n’avait eu de cesse de tenter d’être repoussée, voire refoulée.

Toutefois cet article de Turing ne nous a pas encore livré tout ce que nous pouvons en tirer. Il nous faut à présent continuer de gratter sous l’écorce de cet article afin de dégager les différentes strates sur lesquels il s’établit, dans une démarche qui peut ainsi être qualifiée d’archéologique.

L’article de Turing, dans lequel il expose ses machines conceptuelles et notamment la machine universelle de Turing qui théorise le principe de base de nos ordinateurs actuels, s’intitule Théorie des nombres calculables, suivie d’une application au problème de la décision. On peut faire remonter le « problème de la décision » jusqu’au XVIIe siècle où Gotfried Wilhem Leibniz envisageait de trancher les débats philosophiques en les soumettant à un calcul susceptible de déterminer la véracité ou non d’une proposition exprimée sous forme de symboles. Mais c’est surtout en 1928 que les mathématiciens allemands David Hilbert et Wilhem Ackerman ont posé ce problème de la décision – ou Entscheidungsproblem – sous sa forme définitive : existe-t-il une procédure mécanique – un algorithme – capable de décider si un énoncé mathématique est vrai ou faux ?

Or dans le modèle des machines de Turing, puisqu’il n’y a pas de différence de forme entre les données d'un programme et les instructions de ce programme, on peut passer en donnée d’entrée d’un programme A les instuctions d’un autre programme B. Dès lors, si la tâche du programme A est de calculer si le programme B se terminera ou non, le problème de la décision revient à prouver qu’il existe une machine de Turing A qui puisse déterminer si n'importe quelle autre machine de Turing B possible et imaginable obtiendra au bout d’un certain temps le résultat du calcul pour lequel B est programmée. Et la réponse que Turing donne dans son article de 1933 est négative : on peut prouver qu’il n’existe pas de telle machine A capable de décider si toute autre machine de Turing B s’arrêtera ou continuera à tourner à l’infini. Cette même conclusion avait d’ailleurs été obtenue quasi simultanément et de manière indépendante par Alonzo Church à l’aide de son lambda calcul : l’Entscheidungsproblem n’admet pas de solution.

On voit ainsi que l’ubique, pourtant de nature mathématique, est née d’un échec mathématique : celui du problème de la décision. Mais pour prendre la mesure de cet échec, il nous faut creuser plus profondément dans les strates de l’histoire des mathématiques.

En effet, l’Entscheidungsproblem est lié à l’une des vingt-trois questions posées par David Hilbert en 1900 – précisément au dixième problème demandant de construire une procédure par laquelle on pourrait déterminer en un nombre fini d’opérations si toute équation peut être ou non résolue par des entiers naturels. Hilbert propose son programme de vingt-trois questions comme posant les problèmes essentiels devant être résolus par la recherche mathématique au XXe siècle naissant, afin d’assoir celle-ci sur des base irréfutables. Cette ambition que tout problème mathématique soit soluble vient répondre à ce qui fut nommé à la fin du XIXe siècle la crise des fondements mathématiques.

Celle-ci s’est posée alors que l’emploi irréfléchi de la notion d’infini depuis l’essor du calcul différentiel et intégral au XVIIIe siècle, ainsi que la théorie abstraite des ensembles développée par Georg Cantor au début des années 1880, ou l’apparition de géométries non euclidiennes avaient fait apparaître des paradoxes remettant en cause l’ensemble des mathématiques élaborées depuis l’Antiquité. Or, si l’on ne pouvait plus se fier à la solidité des fondements mathématiques, les ponts et autres édifices basés sur les mathématiques ne risqueraient-ils pas de s’effondrer à leur tour ?

Bref, l’ampleur de cette crise et des conséquences en découlant fut telle qu’elle suscita l’émergence de pas moins de trois écoles concurrentes s’efforçant d’y apporter une solution. Les racines épistémologiques de ces trois écoles sont fondamentalement divergentes, voire conflictuelles et donnèrent parfois lieu à de vives controverses. Malgré tout, ces trois chemins parallèles n’ont pas arrêté de s’entrecroiser, l’un empruntant avec parcimonie des éléments de l’autre afin de progresser. Si bien que les différences se sont aujourd’hui évanouies. Mais ce qui nous importe est que l’ubique ait pu trouver un terrain fertilisant dans chacun de ces trois champs. Examinons-les donc brièvement chacun à leur tour.

Tout d’abord, le logicisme eut l’ambition de rabattre l’ensemble des mathématiques sur la seule logique, en faisant profiter celles-là de la rigueur de celle-ci. On peut faire remonter cette dernière à Aristote et l’idée de réduire l’ensemble des sciences à un langage logique formel capable d’en exprimer les concepts et d’en tirer des déductions logiques à Leibniz. Mais la logique moderne est vraiment née avec George Boole lorsqu’il entreprit au milieu du XIXe siècle de démontrer que les raisonnements logiques étaient soumis à des lois algébriques et pouvaient être transcris sous forme d’équations. La logique passait ainsi du domaine philosophique à celui des mathématiques. Trois décennies plus tard, Gottlob Frege donna le point de départ du logicisme en défendant que l’arithmétique était une branche de la logique, pour laquelle il créa un langage idéographique afin d’en représenter les raisonnements. Son alphabet était certes trop complexe et se heurtait à des paradoxes, mais il servit de base à ce qui fut le grand œuvre du logicisme : les Principia Mathematica d’Alfred North Whitehead et Bertrand Russell. Sur des milliers de pages, ceux-ci tentèrent de faire dériver la totalité des mathématiques, y compris la théorie des ensembles de Cantor, tout en évitant les paradoxes qui s’y étaient fait jour, d’une logique formelle, c’est-à-dire d’un jeu sur des symboles, en dehors de toute signification.

Or c’est là tout le principe de l’ubique théorique : manipuler des symboles en faisant abstraction de leur sens, selon les règles de l’algèbre de Boole, qui n’admet comme alphabet que des 0 et des 1, soit un calcul binaire, dont Leibniz – encore lui ! – formula les bases. Turing lui-même s’inscrit en partie dans cette lignée de logiciens et l’ubique est donc directement issue de cette école du logicisme.

La seconde école de mathématiciens, le formalisme axiomatique, dont la figure de proue fut Hilbert et dont les rangs furent principalement constitués des élèves de ce dernier – parmi lesquels le truculent John Von Neumann, personnage que nous n’arrêterons pas de croiser dans notre enquête – se proposa quant à elle de fonder simultanément la logique et l’arithmétique, en construisant indépendamment les termes logiques et le concept de nombre, se démarquant ainsi du logicisme pour lequel les nombres devaient être déduits des principes logiques. La méthode axiomatique formelle consiste à formaliser une théorie en explicitant les termes de bases utilisés et en se donnant un certain nombre de propositions premières – les axiomes – qu’on admettra comme hypothèses sans démonstrations. À partir des termes premiers et des axiomes, on devait pouvoir déduire l’ensemble des objets et des formules de la théorie. Dès lors, la vérité mathématique fut coupée de la réalité : elle n’était plus ce qui est conforme au réel – une vérité exprimée –, mais ce qui pouvait être inféré des axiomes – une vérité formelle. Pour s’assurer de sa solidité, il suffisait de montrer que la théorie axiomatisée respectait les propriétés d’indépendance des axiomes : aucun axiome ne peut être déduit d’un autre, de complétude : toutes les formules vraies de la théorie peuvent être démontrées à partir des axiomes, et de consistance ou cohérence : on n’aboutit jamais à une contradiction où une proposition et son contraire peuvent à la fois être vrais.

Le but d’Hilbert et de son école fut explicitement que les mathématiques puissent reposer sur l’enchaînement mécanique de règles de déduction à partir des seuls axiomes, cet enchaînement étant purement syntaxique, évacuant toute signification aux symboles employés – davantage encore que dans le logicisme où un certain sens persistait à être attaché aux règles logiques. On voit là que l’ubique se révèle être la technique idéale pour exécuter une telle axiomatique : quoi de mieux qu’un ordinateur pour dérouler mécaniquement, sans erreur et avec une puissance de calcul que ne saurait atteindre aucun mathématicien, des règles strictement définies ? De fait l’ubique sera utilisée pour démontrer des théorèmes jusqu’alors inaccessibles à l’esprit humain en raison du nombre astronomique de calculs nécessité.

Enfin, l’intuitionnisme initié par Luitzen Egbertus Jan Brouwer et poursuivi, entre autres, par Arend Heyting, Kurt Gödel ou Andreï Nikolaïevitch Kolmogorov, s’opposa radicalement à la logique classique, lui reprochant d’appliquer à l’infini des règles uniquement valables dans le domaine du fini, ce qui, selon eux, était la raison pour laquelle des paradoxes s’étaient introduits dans les mathématiques. Ainsi en allait-il principalement du principe du tiers exclus, énonçant qu’une proposition est soit vraie, soit fausse et rien d’autre, et des démonstrations par l’absurde qui en découlent, admettant que si la négation d’une proposition amène à une contradiction, cette proposition peut être considérée comme vraie. Pour l'intuitionnisme, si l'on rencontre une contradiction, il est impossible de décider si la proposition contraire est vraie ou fausse, elle reste indéterminée. L’intuitionnisme exige que les objets mathématiques soit effectivement construits, ce qu’éludent les principes classiques refoulés. En cela, l’intuitionnisme apportait une rigueur supplémentaire, mais amputait les mathématiques de raisonnements depuis longtemps admis, ce qui rebuta bon nombre de mathématiciens.

Cependant, ce constructivisme s’est révélé parfaitement adapté à l’ubique, dont les machines ne sauraient manipuler des objets qui ne sont pas calculés explicitement. La logique intuitionniste permis d’ailleurs d’immenses progrès dans la théorie de l’ubique lorsqu’émergea dans les années 1950-60 l’isomorphisme de Curry-de Bruijn-Howard, établissant une correspondance entre preuves et programmes.

Et ce fut également sur des bases intuitionnistes que Kurt Gödel mit un terme définitif au programme d’Hilbert et aux espoirs de fonder totalement les mathématiques, lorsqu’il présenta en 1931 ses théorèmes d’incomplétude : tout système formel assez complexe pour représenter l’arithmétique contient des formules qui ne sont ni démontrables ni réfutables – mais donc indécidables – et notamment sa cohérence, qui ne peut être démontrée que hors de ce système. En d’autres termes : d’une part, il existe des vérités mathématiques qui restent à jamais hors d’atteinte et, d’autre part, on ne peut décider, en restant au sein d’une théorie, si certaines propositions sont vraies ou fausses. Ou pour en revenir aux machines de Turing : on ne saurait déterminer pour n’importe quelle d’entre elles si elle s’arrête ou non au bout d’un temps fini.

Cette excavation archéologique, dans les strates de l’histoire des mathématiques et particulièrement de la crise de ses fondements, nous ramène donc à notre point de départ. Cependant elle reste riche d’enseignements sur l’ubique. En premier lieu, l’archéologie est venue confirmer et rendre d’autant plus évident ce que la génétique avait déjà identifié : l’ubique n’a pu germer que sur un sol mathématique. Et nous pouvons même ajouter : sur des sols mathématiques, tant se sont révélés tout autant fertiles, des terrains si variés dans leur composition. Et encore, n’avons-nous pas abordé, pour des raisons de concision et de lisibilité, les apports de la théorie des types, de celle des modèles ou de la théorie des catégories, de la métamathématique et de la théorie des démonstrations, ni de l’influence des logiques formelles sur les langages de programmation, ni des recherches en théorie algorithmique de l’information…

Cette excavation archéologique, dans les strates de l’histoire des mathématiques et particulièrement de la crise de ses fondements, nous ramène donc à notre point de départ. Cependant elle reste riche d’enseignements sur l’ubique. En premier lieu, l’archéologie est venue confirmer et rendre d’autant plus évident ce que la génétique avait déjà identifié : l’ubique n’a pu germer que sur un sol mathématique. Et nous pouvons même ajouter : sur des sols mathématiques, tant se sont révélés tout autant fertiles, des terrains si variés dans leur composition. Et encore, n’avons-nous pas abordé, pour des raisons de concision et de lisibilité, les apports de la théorie des types, de celle des modèles ou de la théorie des catégories, de la métamathématique et de la théorie des démonstrations, ni de l’influence des logiques formelles sur les langages de programmation, ni des recherches en théorie algorithmique de l’information…

Mais surtout, l’échec apporté par les théorèmes d’incomplétude de Gödel aux efforts tant logicistes que formalistes ou intuitionnistes de résoudre la crise des fondements mathématiques, nous révèle que l’ubique repose avant tout sur des ruines. On s’était efforcé d’atteindre une connaissance complète et certaine de la vérité mathématique – en la fondant sur la logique, en établissant celle-ci et tout à la fois les mathématiques sur une consistance formelle, ou en se référant à l’intuition de l’esprit du mathématicien au travail – et cela a échoué. Toujours subsiste un reste dans la vérité mathématique, hors d’atteinte par les seuls moyens mathématiques. Cela vient évidemment s’ajouter à l’impossibilité phénoménologique pour l’opération de modélisation de l’ubique de représenter la totalité du réel. Ce réel sera toujours amputé par l’abstraction réalisée par l’ubique, qui doit alors se contenter d’opérer dans le domaine des mathématiques. Mais même au sein de ce royaume des mathématiques, il restera des vérités inaccessibles.

Ce constat devrait tout d’abord inciter à faire preuve de modestie quant à ce dont est capable l’ubique : il ne devrait jamais être question que l’ubique puisse être une solution à n’importe quel problème. Or il existe encore des savants universitaires qui réfléchissent sérieusement à une « théorie ubique du Tout », où notre univers serait le résultat d’un algorithme capable également de potentiellement générer d’autres univers…

Enfin, les tentatives infructueuses de garantir la vérité mathématique se sont traduites par un rejet de plus en plus accentué de la notion de sens. La sémantique elle-même est devenue formelle, c’est-à-dire syntaxe. Ceci est d’une importance fondamentale dans notre enquête, dans la mesure où l’ubique peut être caractérisée comme un traitement d’informations sous forme symbolique, prenant pour objet de ses opérations les symboles « purs », sans référence à ce qu’ils sont censés symboliser. Pour le dire succinctement, le sens est étranger à l’ubique.