déc.212023

Point d'étape sur l’ubique numérique

dans la catégorie Informatologie

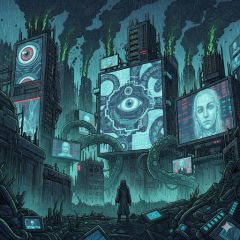

Je comprends tellement que ce monde rêve d’un envers ! De quelque chose qui lui échapperait enfin, irrémédiablement, qui serait comme son anti-matière, le noir de sa lumière épuisante ! L’abracadata qui échapperait par magie à toutes les datas ! Je comprends que la fuite, […], la liberté pure, l’invisibilité qui surgirait au cœur du panoptique, soient les fantasmes les plus puissants que notre société carcélibérale puisse produire comme antidote pour nos imaginaires.

Alain DAMASIO, Les furtifs, Paris, Éditions La Volte, 2019, p. 298-299

On appellera « ubique » tout ce que l’on désigne tantôt par le signifiant « informatique », tantôt – et de plus en plus – par celui de « numérique ».

L’ubique est le nom et l’objet d’une enquête. Celle-ci a pour objectif de déterminer le caractère révolutionnaire ou contre-révolutionnaire de l’ubique. Peut-on se fier et prendre appui sur l’ubique dans une visée émancipatrice ? Ou, au contraire, l’ubique doit-elle être combattue en raison des incomparables moyens de contrôle et de domination qu’elle fournit ?

Notre enquête en est arrivé à un point où, étant parvenu à distinguer ce qui dans l’ubique se conforme et accentue la logique capitaliste – et que nous avons appelé la face numérique de l’ubique –, nous pouvons désormais nous tourner vers l’autre face de l’ubique – si elle existe – susceptible au contraire de nous émanciper de la domination du capitalisme. Pour ce faire, il paraît utile de récapituler dans un premier temps les éléments essentiels composant la substantifique moelle de ce que nous avons nommé « numérique ». S’il s’agit de le combattre, mieux vaut en effet diriger de manière efficiente la lutte sur les points saillants et fondamentaux de l’ennemi, plutôt que s’égarer à partir à l’assaut de ce qu’il laisse ostensiblement à découvert mais qui n’est que leurre, que l’ennemi peut se permettre d’abandonner, car ne remettant nullement en cause sa nature profonde.

La critique du numérique, dénonçant la domination qu’il permet d’imposer au monde avec les dégâts collatéraux qu’il génère et les dangers qu’il soulève, n’a pas attendu notre enquête pour émerger. Cette critique se développe de nos jours selon trois axes principaux : la tyrannie des algorithmes et de l’intelligence artificielle, l’assujettissement aux dispositifs de surveillance numérique, avec les violations de la vie privée que cela entraîne, et l’impact environnemental du numérique, aggravant la crise climatique. Passons en revue ces trois angles d’attaque, ce que nous a appris notre enquête jusqu’ici sur l’ubique nous permettra, d’une part, d’articuler celle-ci avec des questions désormais familières et, d’autre part, d’interroger l’essentialité et donc l’efficacité de ces champs de bataille.

S’il est un sujet qui, depuis quelques années, fait couler beaucoup d’encre, suscitant méfiance, opposition, voire animosité envers le numérique, ou au contraire une adoration béate et l’espoir invétéré qu’il s’agirait de la solution à tous nos problèmes, c’est bien les spectaculaires progrès de l’« intelligence artificielle » (IA). Au point qu’il est devenu commun de vouer aux gémonies tout algorithme, en assimilant grossièrement ce terme aux techniques du domaine de l’IA. Et que dénonce-t-on ou que loue-t-on dans cette IA honnie ou bénie ?

Principalement sa vocation à remplacer l’intelligence humaine. Les élèves, en rendant des devoirs générés par des IA, ne développeraient plus les capacités intellectuelles que le système scolaire est censé les aider à cultiver. Une myriade d’emplois, des journalistes aux artistes en passant par les juges, seraient menacés d’être remplacés par des IA génératives, capables d’accomplir les mêmes tâches, de manière plus rapide, plus économique, plus efficace et sans intervention humaine.

À l’inverse, les laudateurs de l’IA – aussi nombreux que ses contempteurs – voient en celle-ci l’opportunité pour l’humanité de se délester de certaines tâches intellectuelles rébarbatives ou d’en accomplir plus efficacement que ne le ferait le cerveau humain. Les voitures à conduite automatique permettraient ainsi de ne plus avoir à se concentrer sur la route et qu’il soit loisible de se consacrer à d’autre occupations lorsque l’on est au volant. La police et la justice dites « prédictives » seraient enfin à même d’anticiper les crimes afin de garantir à la société de vivre dans une sécurité totale et sans défaut.

Et au milieu de tout ça, dans le microcosme des offices de brevets et des instances régulant le copyright, on s’interroge sur la possibilité ou non de délivrer des titres de « propriété intellectuelle » pour des œuvres ou des inventions entièrement conçues par des IA.

Bref, l’« intelligence artificielle » semble avoir accompli à la perfection la promesse inéluctable à laquelle le choix de ce vocable la déterminait : être comparée – en bien ou en mal – à l’intelligence humaine, l’égaler, voire la surpasser.

La faute à Turing ! Après tout, c’est lui qui, avec son célèbre test, s’est attaché le premier, dans un article de 1950, à répondre à la question de savoir si les machines numériques pouvaient penser. Et à cloisonner les réponses à cette question en la reformulant dans les termes du « jeu de l’imitation » – où d'habitude un joueur masculin s’ingénie à imiter sa concurrente féminine, afin de duper un interrogateur sur son identité de genre : une machine serait décrétée être capable de penser si elle parvient lorsqu’on l’interroge à faire croire que c’est un humain qui répond.

Pourtant, c’est ce même Alan Turing – nous l’avons vu en cherchant la génétique de l’ubique et en en faisant l’archéologie avec son article de 1938 définissant les « machines de Turing » – qui a démontré théoriquement qu’une machine ubique était irrémédiablement incapable de décider s’il existait une solution à un problème si celui-ci n’était pas restreint au domaine du calculable.

Or en quoi consiste l’IA telle qu’elle fonctionne quelques six à huit décennies après ces articles séminaux ? D’une part, elle obéit à une logique très différente des machines de Turing. Celles-ci posent un ensemble de règles logiques explicites que la machine doit suivre pour exécuter ses opérations. C’est ainsi que le développement de logiciels est effectué lorsque l’on programme classiquement : on indique à l’ordinateur que s’il se trouve dans telle ou telle situation, alors il doit accomplir telle ou telle opération, qu’on le force éventuellement à répéter tant que telle ou telle condition est satisfaite. Il n’y a rien de plus intelligent dans le fonctionnement classique d’un ordinateur : il exécute bêtement les enchaînements logicomathématiques qu’on lui donne sous forme d’instructions explicites dans un langage de programmation. Et l’on a bien du mal à appeler cela « intelligence » !

Il en va tout autrement des algorithmes actuels dits « d’intelligence artificielle » et qui reposent principalement sur l’apprentissage profond – deep learning – de réseaux de neurones. De tels réseaux sont constitués de petits programmes ubiques n’ayant pour seule instruction que de s’activer ou rester en sommeil selon qu’un seuil est atteint par l’activité des cellules voisines auxquelles ils sont reliés. Ce qui donne lieu à la mise en branle de circuits permettant d’emprunter des chemins conduisant à tel ou tel résultat. Mais ces résultats restent largement inexplicables même par celles et ceux qui ont programmé ces réseaux artificiels de neurones, ceux-ci configurant eux-mêmes les chemins logiques qui seront effectivement empruntés sans que l’agencement de ces itinéraires soit connu a priori. On entraîne ces réseaux avec des corpus de données gigantesques, ce qui leur permet d’en déduire des règles statistique suffisamment fiables pour, après la phase d’apprentissage, prédire un résultat correct à partir de nouvelles données.

C’est ainsi que lorsque des millions d’utilisateurs auront indiqué reconnaître sur des images de captcha un passage piéton, l’algorithme d’IA d’une voiture à conduite automatique sera capable de déduire statistiquement, de manière probabiliste, que les données reçues en temps réel par une caméra embarquée reproduisent une configuration de son réseau neuronal similaire, avec un degré d’incertitude suffisamment faible, à la configuration qu’il a enregistrée à partir de ses données d’apprentissage… et qu’il faut donc ralentir et rester vigilant si une forme suffisamment proche d’un humain s’engage sur ce passage piéton.

De la même manière, en entraînant un algorithme d’IA, destiné à converser avec des humains, avec un modèle massif de langage – LLM : Large Langage Model –, il sera en capacité de prédire quel groupe de mots doit suivre statistiquement le précédent pour former une phrase correcte donnant l’impression que l’algorithme – avec sa faculté de capturer statistiquement une grande partie de la syntaxe et de la sémantique du langage humain – répond à la question de manière sensée, comme l’aurait fait un humain.

Mais, d’autre part, il a été démontré que ces réseaux de neurones – dans lesquels on aura reconnu les neurones formels de McCulloch et Pitts et les automates de von Neumann – étaient équivalents à une machine de Turing. C’est-à-dire qu’ils sont tout autant limités à n’exécuter que des fonctions mathématiques uniquement aptes à résoudre des problèmes du domaine du calculable. Il n’y a donc pas plus d’« intelligence » dans l’IA. Juste des mathématiques qui, plutôt que suivre un enchaînement logique explicite, reposent sur des calculs probabilistes.

La comparaison avec l’intelligence humaine n’a tout bonnement pas lieu d’être. L’« intelligence artificielle » aurait dû se nommer « calcul statistique automatisé ». Cela aurait certes été moins « vendeur » et généré moins de fantasmes alarmants ou enthousiastes, mais on aurait ainsi évité de considérer que ses risques ou ses apports résidaient uniquement dans la comparaison avec l’intelligence humaine. Lorsque l’on évoque l’IA, on parle en fait de la fiabilité des statistiques pour prendre des décisions, mais cela n’a rien à voir avec une quelconque intelligence. Et c’est cette fiabilité qu’il convient de mettre en doute selon les questions auxquelles elle est appliquée.

Le calcul statistique opéré par une IA pour faire des prévisions météorologiques ne pose en soi pas de gros problèmes la plupart du temps, d’autant plus que sa précision est susceptible de s’améliorer par rétroaction en comparant les prévisions avec les phénomènes réellement observés. S’imaginer qu’une œuvre produite par une IA puisse non seulement rivaliser mais tout bonnement être comparée à une création d’un cerveau humain, c’est ne pas comprendre que les deux jouent sur des terrains complètement différents : d’une part, la seule sphère du calculable, d’autre part, le champ non seulement de la logique rationnelle, mais également l’étendue infinie de l’intuition, de la sensibilité et des affects. Priver quelqu’un de liberté, parce qu’une IA aura statistiquement prédit que ce quelqu’un était susceptible de commettre un crime dans le futur dont il devrait automatiquement être jugé coupable, ne devrait pas sortir du domaine de la science-fiction. Même les précogs produisent des rapports minoritaires qui se révèlent cependant correspondre à ce qui s’est finalement passé dans la réalité.

Ce que notre enquête doit retenir de l’intelligence artificielle, c’est qu’elle n’est qu’une autre méthode mathématique, toujours aussi limitée à ne s’appliquer qu’à ce qui est du domaine du calculable – à quoi ne peut se résumer la réalité.

Et que ce soit précisément le domaine mathématique des probabilités et des statistiques – c’est-à-dire des lois sur les grandes quantités de nombres – qui s’applique à l’IA, devrait être un indice de sa conformité aux principes capitalistes de la comptabilité et des livres de comptes, de la valeur et de l’abstraction de la réalité à ce qui est quantifiable, réductible à un nombre, – bref, au numérique.

La surveillance permise par les technologies numériques est un autre objet de critique en vogue ces dernières années. Disons-le d’emblée : cette contestation, le constat qu’elle établit et les craintes qu’elles dénoncent, sont parfaitement justifiés. Oui, le numérique permet de mettre en place entre les mains d’États ou de corporations, une connaissance sans précédents des faits et gestes, des actes, et même des pensées de tout un chacun. Il a même été forgé le terme de « capitalisme de surveillance » pour désigner le stade actuel de la domination du capitalisme, reposant sur l’extraction de données numériques. Et oui, c’est quelque chose contre lequel il faut se battre, tant cela nuit à notre épanouissement individuel et collectif et à l’exercice de nos libertés afférentes, au profit d’une domination accrue d’une poignée d’individus sur le reste d’entre nous. Encore faudrait-il s’attaquer au mal à la racine… Car à quoi se résument ces critiques de la surveillance numérique ? À deux effets pervers selon le type d’acteur visé.

D’un côté, lorsqu’il s’agit des États et services de renseignement, la critique est dirigée contre la démultiplication des moyens de surveillance de leur population que confèrent les outils numériques. Le numérique n’est au fond pas en cause. Ce qui l’est, c’est la surveillance en elle-même, le numérique ne venant jouer qu’un rôle de facilitateur, d’accélérateur et d’amplificateur de cette dernière. Au fond, la critique est la même qu’elle l’était, avant l’avènement du numérique, lorsque la surveillance d’État s’exerçait par des moyens analogiques : espionnage, mouchardage, délation, interception des correspondances, écoutes téléphoniques, etc. Quelle que soit la manière dont l’État épie ses propres citoyens, que ce soit analogiquement ou numériquement, cela lui procure des moyens coercitifs de contrôle sur sa population, privant incidemment celle-ci de libertés fondamentales, telles, qu’entre autres, celle d’aller où bon lui semble, d’exprimer ses pensées quelles qu’elles soient ou de se réunir avec qui l’on désire. Et c’est ce contrôle étatique qui est inacceptable et que l’on doit combattre.

D’un autre côté, l’État, à l’heure du numérique, n’est plus le seul acteur à exercer une surveillance. Les entreprises privées se livrent également à cette activité avec une ampleur qui n’a rien à envier aux services étatiques, au point que ceux-ci recourent fréquemment à celles-là pour bénéficier de la masse astronomique de renseignements qu’elles collectent déjà pour leurs propres besoins. Ces besoins qu’ont les entreprises de se livrer à une surveillance de leurs usagers relèvent de deux ordres. Tout d’abord, il peut s’agir d’améliorer le service qu’elles vendent – ou plus souvent, qu’elles offrent – à ces utilisateurs. Et cela ne soulève aucun émoi. Là où les critiques se font jour, c’est justement lorsque les usagers ne sont absolument pas considérés comme les clients des entreprises et que la surveillance qui s’exerce sur eux a pour objectif la satisfaction des véritables clients ou, plus prosaïquement, l’accroissement des bénéfices propres des entreprises. L’exemple paradigmatique est celui de Google, qui se sert des données collectées par l’utilisation de son moteur de recherche pour améliorer les résultats de ce dernier, mais également – et de plus en plus principalement – pour fournir aux annonceurs qui sont ses véritables clients, des renseignements suffisamment détaillés et pertinents sur les profils d’utilisateurs pour placer des publicités ciblées.

La critique est alors que les utilisateurs abandonnent gratuitement une masse de données personnelles dont les entreprises se servent et qu’elles monnaient pour leurs propres profits. En agissant ainsi, on leur reproche, d’une part, d’attenter au droit fondamental à la vie privée des usagers et, d’autre part, de générer des bénéfices sur le dos de ceux-ci sans qu’ils n’en voient la couleur. Ces deux critiques nous semblent mal placées.

Celle sur l’attentat à la vie privée car elle n’a pas lieu d’être, dans la mesure où aucune donnée personnelle n’est collectée qui n’a été livrée par l’utilisateur lui-même sur le réseau public qu’est Internet. Pour faire court, rien n’est privé sur Internet. Par nature, tout ce qu’on y fait ou dit doit être considéré comme public. Ne serait-ce que parce qu’on le fait ou qu’on le dit dans des commentaires sur un site web, dans une publication sur un réseau social ou dans un courriel, auquel l’éditeur de ce site, les employés du réseau social ou ceux du service gérant les mails, sans parler des intermédiaires techniques par lesquels transitent ces données, comme notre fournisseur d’accès Internet par exemple, ont techniquement accès. Tout au plus peut-on cacher par des moyens cryptographiques le contenu de ce que l’on échange. Mais, outre le fait qu’aucune méthode de chiffrement n’est garantie ne pas pouvoir être cassée un jour ou l’autre, on ne masque pas ainsi un certain nombre de métadonnées – le destinataire du message, la date et l’heure à laquelle il est émis et reçu, etc. – qui peuvent tout autant intéresser la surveillance, qu’elle soit privée ou étatique.

Au passage, c’est pourquoi la surveillance numérique d’État qui prend pour prétexte la lutte contre le terrorisme, au mieux sous-estime l’intelligence de ses ennemis, au pire est un leurre. Toute activité criminelle, pis encore si elle risque d’être qualifiée de terroriste, ne saurait se dérouler en ligne. Car elle serait alors de fait publique et susceptible d’être découverte. Au grand dam des décideurs politiques, facilement enclins à rassurer leurs électeurs en invoquant un solutionnisme technologique, les professionnels du renseignement ne cessent de le rappeler : ce dont ils ont besoin, c’est de moyens humains davantage que de légalisation de leurs moyens numériques.

Quant à la critique sur le profit engrangé sans rétribution des utilisateurs, elle se condamne à être malvenue tant qu’elle vise un des principes du capitalisme sans remettre en cause celui-ci. Quoi ? Une entreprise capitaliste fait du profit et ce serait intolérable ? Mais allons ! C’est là sa raison d’être. Oui mais elle gagne de l’argent grâce aux actions des utilisateurs – certains vont même jusqu’à dire : grâce à leur travail – qui devraient être de ce fait rémunérés. La belle affaire ! Quand bien même les usagers d’un service numérique seraient considérés comme ses clients, la valeur d’une marchandise d’un point de vue capitaliste n’est jamais réalisée que grâce à ceux-ci lorsqu’ils l’achètent. Et faire entrer dans le rapport spécifiquement capitaliste du travail, des actes effectués librement sans la contrainte du cadre du salariat, est une hérésie renforçant la sphère d’emprise du capitalisme. Si l’on veut critiquer le fait que la surveillance numérique engendre des profits, c’est plutôt à la notion même de profit qu’il conviendrait de s’attaquer.

Non, ce qui nous paraît plus pertinent serait de bien voir que la surveillance, tant étatique que privée, repose sur la mise en données numériques des actions et comportements des personnes et qu’elle les réduit à cela et uniquement à cela. Car ce sont uniquement ces données numérisées qui peuvent être manipulées, analysées, recoupées et, par la suite, permettre d’anticiper des actes et comportements futurs et contrôler, ainsi qu’orienter ceux-ci.

C’est ce que notre enquête a très tôt soulevé : l’ubique consiste en une abstraction de la réalité, modélisant celle-ci sous forme mathématique, opérant sur ces modèles et restituant les résultats de ces opérations au réel, agissant ainsi sur celui-ci et le modifiant à sa guise – ou presque. « Presque », car c’est une illusion de croire que les modèles numérisés captent l’intégralité du réel. Les données numériques collectées par les États ne représentent jamais dans toute leur complexité les personnes réelles qu’ils veulent surveiller. Celles compilées par des entreprises afin de vendre des profils d’utilisateurs ne seront jamais qu’une pâle imitation incomplète de ceux-ci.

Ce qui devrait être critiqué dans la surveillance numérique, c’est l’opération même de numérisation de la réalité. Dans la mesure où une fois celle-ci effectuée, on en oublie l’irréductible incomplétude de cette numérisation et l’on en tire des décisions comme si elle ne l’était pas, décisions qui ont pourtant des effets directs sur le réel complet et entier.

Il en va de même en ce qui concerne le troisième type de critique que nous nous sommes proposés de passer en revue ici : celle sur l’impact écologique du numérique. Cette dernière critique a l’immense mérite de soulever que les opérations mathématiques abstraites du numérique reposent sur des ressources bel et bien concrètes. On a besoin de matériaux pour construire les équipements et éléments de réseaux et l’on a besoin d’énergie pour les faire fonctionner. Le constat est juste, important et salutaire.

Il en va de même en ce qui concerne le troisième type de critique que nous nous sommes proposés de passer en revue ici : celle sur l’impact écologique du numérique. Cette dernière critique a l’immense mérite de soulever que les opérations mathématiques abstraites du numérique reposent sur des ressources bel et bien concrètes. On a besoin de matériaux pour construire les équipements et éléments de réseaux et l’on a besoin d’énergie pour les faire fonctionner. Le constat est juste, important et salutaire.

De ce constat, la critique environnementale du numérique n’en tire guère d’autre conclusion que la recommandation d’une incitation à la sobriété numérique, que celle-ci prenne la forme de réglementations contre l’obsolescence programmée, de préconisation d’achats d’occasion ou de matériels reconditionnés, de limitation du nombre et de la taille des écrans ou du volume et de la qualité des vidéos, ou qu’elle aille jusqu’au questionnement des besoins en matière de conception de logiciels pour éviter les fonctionnalités inutiles. Le point le plus avancé de cette critique semble atteint lorsqu’elle affirme que tout n’a pas besoin d’être numérisé mais – est-ce par crainte d’aller trop loin ? – les exemples cités sont alors les services publics et d’entreprise.

Sans nous étendre davantage dans la critique de la critique, constatons que ce que notre enquête a montré nous permet de pousser cette critique environnementale à un stade supérieur, seul susceptible d’avoir une effectivité réelle.

En effet, qu’est-ce qui motive cet accroissement de la numérisation et corrélativement des besoins en matériels et énergies préjudiciables à l’environnement ? Ici encore, c’est la croyance en la complétude des modèles numériques pour représenter et agir sur la réalité. Et in fine cette croyance est celle de la phase du capitalisme que nous avons qualifiée de cybernétique. C’est la logique même du capitalisme d’exiger une croissance sans cesse renouvelée de la production de valeur et des profits ainsi générés. Le numérique – et plus globalement les technologies – ayant été élevé comme source de valeur à notre époque – à tort ou à raison, nous y reviendrons dans un futur volet de notre enquête –, le capitalisme ne peut que souhaiter et imposer son extension.

Ouvrons ici une parenthèse pour remarquer que cela rejoint le problème de la surveillance numérique. À un stade précoce, sa principale incarnation résidait dans le projet Échelon d’interception des communications numériques, mené conjointement par les États-Unis, le Royaume-Uni, le Canada, l’Australie et la Nouvelle-Zélande dès l’après-guerre. Lorsqu’il fut révélé à la fin des années 1980, une stratégie de lutte contre la surveillance d’Échelon a été de sursaturer ses capacités d’interception en générant ponctuellement une masse de données numériques telle qu’Échelon ne pouvait digérer. Une telle stratégie n’est plus possible aujourd’hui, car — et cela rejoint également le problème de l’« intelligence artificielle » – la surveillance numérique utilise de nos jours les techniques statistiques de l’IA, pour lesquelles plus le volume de données est important, plus le résultat sera fiable. Fin de la parenthèse.

Dès lors, la critique environnementale ne peut faire l’économie d’une remise en cause radicale du capitalisme.

Et c’est bien là tout l’objet de la de la suite de notre enquête. Il nous faut découvrir – tant est que cela est possible – ce qui dans l’ubique permettrait d’attaquer le capitalisme en plein cœur. C’est-à-dire contrecarrer le pôle numérique de l’ubique. C’est pour cette raison que nous avons ici plus parlé de numérique que d’ubique. Car ce qui doit être visé par la critique, c’est précisément sa face numérique. Et effectivement, même si elles n’en ont pas conscience et malgré les lacunes que nous avons soulignées, les trois grandes catégories de critiques présentées ici s’adressent explicitement au numérique. Jamais à l’informatique.

Il est donc grand temps d’explorer le pôle informatique de l’ubique.